Szinte minden fantasztikus filmben és könyvben láthatunk és olvashatunk víziókat és elképzeléseket arról, hogy a...

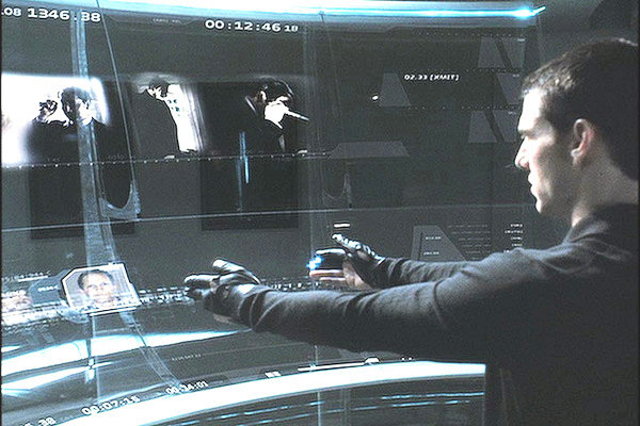

Szinte minden fantasztikus filmben és könyvben láthatunk és olvashatunk víziókat és elképzeléseket arról, hogy a jövőben bizony már nem képernyők segítségével fogunk kommunikálni számítógépeinkkel, és egyéb IT-eszközeinkkel. Ki ne ismerné a „Különvélemény” c. film csodásan megvalósított térbeli, érintésre működő kivetítőjét? De nem is kell a tudományos fantasztikum világába kalandoznunk, elég ha a Microsoft interaktív falra gondolunk, vagy a különböző 3D-s megoldásokra.

Tucat számra hallunk (illetve esetünkben adunk hírt) minden évben az ilyen és hasonló eszközökről, prototípusok jelennek meg és néha tűnnek el, a történet vége azonban mindig ugyanaz: még mindig a „jó öreg”, kétdimenziós monitorok előtt üldögélve végezzük a munkánkat, netezünk és szórakozunk. Igaz, a monitorok egyre vékonyabbak, a felbontásuk egyre nagyobb, de az alapkoncepció nem változik: eljött 2011, és még mindig nem „vetítünk a falra”, nem lebegnek előttünk a levegőben a Windows ikonok, és nem „sikáljuk a képet”, ahogy a már említett Spielberg-klasszikusban nevezik a kijelző használatát. Hogy a helyzet változni fog-e a jövőben, vagy még jó darabig a hagyományos monitorokat használjuk-e, arra most nem fogunk egyértelmű választ adni, ellenben vizsgáljuk csak meg kicsit a múltat! Hogyan is kezdődött, miért lett a monitor egyeduralkodó a számítógéppel való vizuális kommunikáció terén? Sőt, milyen lehetett az első számítógépes kijelző?

Egy géppel való kommunikáció két részből áll: bevitel és visszacsatolás, azaz input (ezek vagyunk mi, a felhasználók) és output (ez az, amit visszakapunk a géptől). Ezt a két alaplépést ismételgetve zajlik minden, így volt ez a hetvenes években is, és a mai napig így van, legyen szó internetezésről, munkáról vagy akár játékról. A számítástechnika hőskorában a gépekkel való kommunikáció bináris szinten zajlott. Ez gyakorlatilag annyit tesz, hogy kettes számrendszerben (nullák és egyesek) kellett a gépekbe vinni minden adatot. A bevitel (input) azóta sokat fejlődött, a lyukszalagoktól eljutottunk a billentyűzetig, az egérig, érintőképernyőig, fényceruzáig; apropó, maga az egér sem lesz leváltva egy darabig, erre vonatkozó írásunk itt olvasható.

A visszacsatolás (output) azonban nem esett át olyan hatalmas fejlődésen, mint a bevitel. Már az első óriásgépek esetében is nyilvánvaló volt, hogy a legegyszerűbb, ha az output (ami akkoriban nem volt más, csak szöveg) egyfajta televízióra hasonlító kijelzőre érkezik, megspórolva ezzel a nyomtatást és kényelmesebbé téve az adatok értelmezését, elemzését.

Az egyik legelső modell, amely már „grafikus” outputra is képes volt, az IBM 701-es gép, 1952-ből. Igaz, ekkor még kétfajta módon jöttek az adatok: egyrészt nyomtatásban (a szöveg számára, mivel „betűket” nem tudott még a kijelző), de már ekkor megjelent a nyomtatási kimenet mellett egy másik felület is: a képernyő. Két évvel később már grafikus megoldásokat is kínált az IBM: az 1954-ben megjelent, 704-es modell tartalmazott egy kijelzőt, igaz, akkor még nem monitor, hanem „Cathode Ray Tube Output Recorder” volt az eszköz neve.

Túl sokat nem tudott, viszont rá lehetett kapcsolni egy kamerát (ez volt egér helyett a beviteli eszköz), hogy azután a kamera mozgásának megfelelően, egy analóg-digitális átalakító segítségével vonalakat és görbéket (és persze pontokat, bár akkor még nem „pixel” volt a nevük) lehessen rajzolni a kijelzőre. Ebből is látszik, hogy a grafikus megoldásokra már fél évszázaddal ezelőtt is nagy volt az igény. A katódsugaras kijelző volt tulajdonképpen az első „vektorgrafikus” kijelző. Az eszköz 8000 pontot tudott kirajzolni másodpercenként, így elméletileg akár komolyabb grafikákat vagy képeket is meg tudott volna jeleníteni. Elméletileg…

Legnagyobb hátránya az volt, hogy maga a rajzolási folyamat gyakorlatilag elhasználta az összes processzoridőt, és még így is erősen limitáltak voltak a lehetőségek. Szövegeket (betűket) például még nem tudtak vele megjeleníteni (egy betű, ha jobban belegondolunk, elég bonyolult ábrának számít vektorgrafikus alapokon, nem is beszélve egy teljes mondatról), csak egyszerűbb ábrákat, szinuszokat stb. Ennek ellenére a legtöbb forrás innen, 1954-ből származtatja a monitorokat, és a 704-es kijelzőjét emlegetik a „világ első monitoraként”.

Az első CRT tehát nem volt áttörés, az igény azonban már felmerült egy kénylmesen használható kijelzőre, sőt az IBM már nevet is adott a jövőbeni eszköznek: VDU-nak, azaz „Visual Display Unit”-nak keresztelték, de sokáig nem volt más, mint ködös elméletek és papíron létező koncepciók összessége.

Az első áttörés a hatvanas évek elején történt, és Ivan Sutherlandnek köszönhető. Sutherland látta meg ugyanis a lehetőséget a 704-eshez kapcsolt kijelzőben, a kamerával összekötött kijelző megoldást azonban nem tartotta életképesnek (nagyon helyesen). Sutherland egy tollszerű beviteli eszközre koncentrált, az eredeti vízió az volt, hogy a 704-es kamerájához hasonlóan egy tollal lehessen „megmutatni” a gépnek, hogy mit is rajzoljon a monitorra. Még szoftvert is készített hozzá „Sketchpad” néven, ez azonban soha nem jelent meg. Sutherland prototípusa azonban már kezdett hasonlítani egy igazi monitor/gép kombóra – képes volt ábrákat, egyszerűbb rajzokat megjeleníteni, igaz, csak egyfajta virtuális papír jelleggel működött, hiszen mindent a felhasználónak kellett „rárajzolnia” a monitorra egy fényceruzával. Szerencsére sokan láttak fantáziát a dologban, no nem a fényceruzában, hanem a kijelzőben.

A General Motors, a MacDonald Douglas és a Ford (bizony, nem csak autók gyártásával foglalkoznak) együtt kezdte el keresni a megoldásokat egy gyors, katódcsöves, ábrák és szövegek megjelenítésére egyaránt képes eszköz, a már említett VDU kifejlesztéséhez. Erőfeszítéseik sikeresek voltak: 1964-ben megjelent az IBM 360, és hozzá a „2250 Vector Graphics Display” névre hallgató eszköz, azaz egy monitor. Megdöbbentő lehet, de a 2250 felbontása 1024x1024 volt, ami még mai szemmel is jónak számít. A képfrissítés 40 kép/másodperc (fps) volt (nem keverendő össze a mai Hz-ben számolt adatokkal), de ez nem konstans – attól függően csökkent, hogy milyen bonyolult képet kellett megjeleníteni a kijelzőnek. A megjelenítendő ábrákat egy speciális memóriából szedte a gép (tulajdonképpen volt egy megosztott memória a gép és a kijelző számára), a kurzort pedig a Sutherland-féle fényceruzával lehetett mozgatni.

A további IBM kijelzők is ezt az elvet követték: mindent vektorgrafikával rajzoltak ki. Érdekesség, hogy a hetvenes években (1977-ben mutatták be) készült Star Wars jeleneteiben már használták a vektorgrafikát – IBM gépek és kijelzők segítségével készítették például a híres fénysebesség-effektust. Mindez jól példázza, nagyjából mire volt képes az akkori kijelzőtechnika: főleg fekete alapon fehér (vagy zöld) vonalak megjelenítésére…

Valami még mindig hiányzott, ez pedig a GPU, azaz a grafikus processzor volt. Az IBM-féle megosztott memória és elosztott processzoridő komoly korlátokat állított a megjelenítő hatásos használata elé – egy olyan megoldásra volt szükség, ami leveszi a terhet a számítógép válláról, és önállóan kezeli a kijelzőre kerülő információk megjelenítését és frissítését.

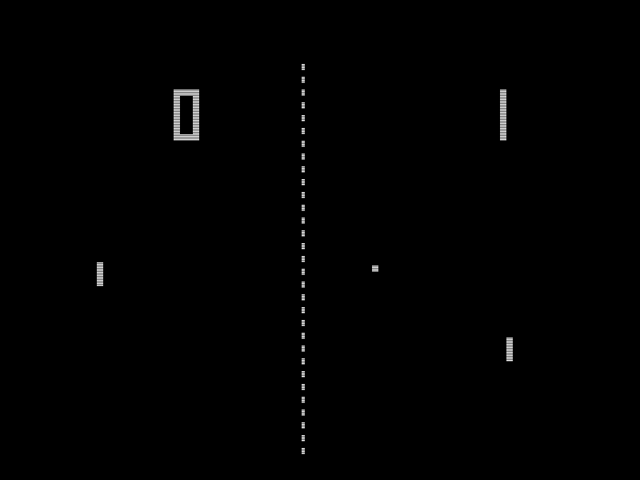

A megoldás 1972-ben érkezett, érdekes módon nem a tudományos laboratóriumokból, hanem a szórakoztatóiparból: egy gép, Nolan Bushnell és Ted Dabney mérnökök találmánya, az Atari műhelyéből. A szerkentyűt úgy hívták, hogy „Pong”, és egy játékmasina volt. A Pong hatalmas siker lett, megtalálható volt szórakozóhelyeken, Las Vegasban, de készült belőle otthoni „konzol”, sőt hordozható verzió is. Bár sokféle változata készült, egyvalamiben minden Pong-játék egyforma volt: a fekete alapon fehér ábrákat (tulajdonképpen vonalak és kockák) nem a processzor, hanem egy külön egység, a GPU számolta. Így történt, hogy a Pong képes volt olyan gyorsan rajzolni (speciális, ún. „Raster Scan” grafikát használt a gép) és számolni egyszerre, hogy végül egy, a mai napig élvezetes „virtuális tenisz” jöhetett létre a kijelzőn. A Pong sikere mindenki számára egyértelművé tette, hogy GPU-ra, azaz grafikus processzorra van szükség, külön kell kezelni a grafikát és magát a processzort.

A következő áttörés a nyolcvanas évek elején következett be: ekkor robbantak be a köztudatba az otthoni számítógépek, ezekből is a legnépszerűbbek, a Commodore cég kisgépei. (Részletes Commodore történelem itt.) A forradalmi újítás a kijelzők terén az volt, hogy egész egyszerűen nem adtak a géphez kijelzőt! Ellenben olyan grafikus chipet építettek bele (és persze csatlakozót), amivel egyszerűen lehetett csatlakoztatni a gépet szinte minden akkori televíziókészülékre, legyen akár színes, akár fekete-fehér. Ráadásul a gép, a világ akkoriban legjobb grafikus processzorát, a VIC-et (Video Interface Chip) is tartalmazta: 16 színű, nagyfelbontású grafika, 320x200-as felbontással, ez volt a gép szíve; aki csak meglátta a fantasztikus színeket és felbontást, rögtön beleszeretett. Az IBM is próbálkozott, a Commodore-ral azonban nem tudott versenyezni: ők a CGA (Color Graphics Adapter) videokártyát kínálták, az amúgy sem túl olcsó alapgép mellé, és így is csak négy szín volt elérhető a 320x200-as felbontásban.

Az irány már megvolt: a GPU szolgáltatja a képet, és egy gépre kötött televízió a megjelenítést. A „televízió a gépre” irányvonal egészen a nyolcvanas évek végéig (Amiga számítógépek) tartott, a piac azonban hamar reagált, és megjelentek a speciális CRT „televíziók”, kifejezetten otthoni számítógépekhez, majd eljött a TFT és LCD-k korszaka, de a történetet innen már ismerjük.

Mit hoz a jövő? Nos, a GPU+kijelző párosítás valószínűleg még nagyon sokáig velünk marad, mint ahogyan az is valószínű, hogy a nem monitoros megoldások (vetítőfal, szemüveg, térben lebegő képek) még jó ideig csak prototípusok maradnak. Mi sem példázza ezt jobban, hogy bár az IBM 704-es kijelzőjének megjelenése óta több mint fél évszázad telt el, az alapszituáció, GPU ide vagy oda, nem sokat változott. Jelen sorokat egy monitorra bámulva írom – a kedves olvasó pedig egy monitoron keresztül olvassa.

De azért a Különvélemény-féle „képsikálós” kivetítőből biztosan vennék egyet, ha lehetne már kapni…

Ajándékozz éves hvg360 előfizetést!

Ajándékozz éves hvg360 előfizetést!