Miniatűr robotokon alkalmaztak a Google DeepMind részlegének szakemberei egy olyan tanulási metódust, amelyhez hasonlóval a jövőben az embert segítő humanoid robotokat is kiképezhetik.

A mesterséges intelligencia (MI) és a robotika kutatói régóta dolgoznak már azon, hogy egy olyan általános intelligenciát hozzanak létre, amely segítségével a robotok ugyanolyan ügyességgel, mozgékonysággal és megértéssel tudnak közlekedni a fizikai világban, mint az állatok vagy az emberek. A fejlesztés évek óta tart, középpontjába az utóbbi időben a mély megerősítő tanulás (deepl reinforcement learning, DLR) került.

A munkálatok állását egy robotok által lejátszott focimeccsen demonstrálták. Miközben négylábú robotok már rendkívül ügyesen tudnak játszani, és jó a labdavezetésük is, a kétlábú társaik még esetlenek. Ennek oka főként azt, hogy az alapvető készségekkel kell elsősorban foglalkozniuk a kutatóknak a stabilitás és a hardver adta korlátok miatt.

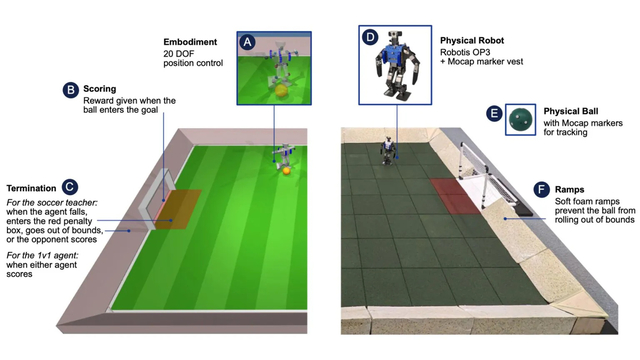

A DLR azt a két tanulási stratégiát ötvözi. A Google DeepMind kutatói ezt használva olcsó miniatűr robotokat próbáltak megtanítani focizni, és arra, hogy egy az egy ellen játszanak mérkőzéseket. A szimulált és a fizikai világban végzett kísérletek eredményeit a Science Robotics című tudományos szaklapban publikálták.

Kezdetben két területre fókuszáltak: az egyik az volt, hogy miként tudnak felállni a robotok a földről, a másik pedig, hogy miként tudnak gólt szerezni egy képzetlen ellenféllel szemben. A megerősítő tanulás hatékonynak tűnik, a robotok ugyanis megtanultak gyorsan felállni, helyesen járni, fordulni és rúgni, valamint könnyedén váltogattak ezek között – foglalja össze a tanulmányt az Interesting Engineering.

Ezen kívül a robot képes volt hárítani az ellenfél lövését, és előre jelezni, hogy merre fog mozogni a labda. A szakemberek szerint a képességek manuális fejlesztése nem volna praktikus, hiszen a robot mindig az adott körülményekhez igazodva kell, hogy reagáljon.

A szakemberek szerint a szimulált környezetben lejátszott mozgási stratégiát nagyon könnyen sikerült átültetni a valós robotokra. A kísérleti mérkőzéseken kiképzett robotok 181 szálzalékkal gyorsabban mentek, 302 százalékkal gyorsabban fordultak, 34 százalékkal gyorsabban rúgták a labdát és 63 százalékkal gyorsabban keltek fel egy esés után, mint azok az eszközök, amelyek csak egy forgatókönyv szerinti alapismeretek alapján játszottak.

A kutatók szerint mindez lehetővé teszi, hogy a humanoid robotokat biztonságos mozgásra, valamint egy dinamikus környezetben is kifinomult mozgásra lehessen megtanítani.

Ha máskor is tudni szeretne hasonló dolgokról, lájkolja a HVG Tech rovatának Facebook-oldalát.

Ajándékozz éves hvg360 előfizetést!

Ajándékozz éves hvg360 előfizetést!