Amerikai kutatók olyan gépi tanulási modellt fejlesztettek ki, amely képes megszólaltatni azt a zenét, amit csak úgy magának, a fejében játszik le az ember.

Gondolatban lejátszhatunk magunknak egy dalt, és biztosak lehetünk abban, hogy ezt senki sem hallja. Vagy mégis? A Kaliforniai Egyetem kutatói mindenesetre egy igazán érdekes kísérletről számoltak be a napokban: gépi tanuláson alapuló képes dekódolni az agyi tevékenységet, mármint abban az értelemben, hogy megszólaltathatja a Pink Floyd együttes The Wall című albumáról vett klasszikusát, az Another Brick in the Wallt.

Azzal, hogy a kutatók közvetlen emberi agykérgi felvételekből rekonstruálták az említett zeneszámot, betekintést nyújtanak a zeneészlelés idegi alapjaiba és a jövőbeli agyi dekódolási alkalmazásokba. Ez a rendszer, írják a Plos Biology folyóiratban, felhasználható lenne a jövőbeli agy-számítógép interfész (BCI) technológiáihoz, amelyben csupán az elme segítségével újrateremthetnék a zenét.

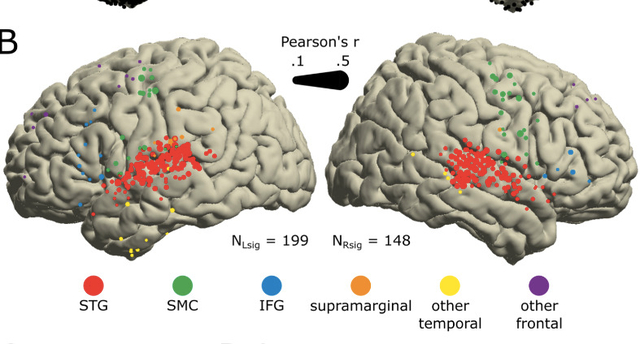

Kísérletükben az idegtudósok 2668 intracranialis EEG elektródát erősítettek 29, epilepszia miatt műtött páciens agyára, miközben azok az Another Brick in the Wall (Part 1.) című dalt hallgatták. A hallásfeldolgozásért és a ritmusérzékelésért kifejezetten az agy felső halántéki tekervényében (superior temporal gyrus, STG) elhelyezkedő elektródák a felelősek, és ezek szolgáltatták a legjobb adatokat a zene rekonstruálásához.

Azt is megállapították, hogy minél több elektródaadatot tápláltak be a modellbe, annál pontosabban lehetett rekonstruálni a dalt. Szintén kiderítették, hogy az agy mely régiói és a dal mely részei a legfontosabbak a rekonstrukció szempontjából. A ritmushoz kapcsolódó elektródák eltávolítása például silányabbá tette a rekonstrukciót.

Míg a korábbi hasonló kísérletek az agy beszédmotoros kéregének elektromos aktivitását dekódolták (ez egy olyan terület, amely szabályozza az ajkak, az állkapocs, a nyelv és a gége apró izommozgását, amelyek szavakat alkotnak), a mostani vizsgálat az agy hallórégióiból származó felvételekre fókuszált, ahol a hang minden aspektusa fel van dolgozva.

Az alábbi videó elején (a 7. másodperctől a 13. másodpercig) azt hallhatja, ahogyan a kísérlet résztvevőinek lejátsszák a zenét, majd rögtön utána (16–22. másodpercek között) hallható, hogy a zene ismerete nélkül, csupán agyból kiolvasott jelek alapján mit rakott össze a mesterséges intelligencia.

A kutatók azért megjegyezték, hogy nem volt adatuk arról, hogy alanyaik mennyire ismerték a dalt, ami személyenként befolyásolhatja az eredményeket. Azt is elmondták, hogy a jövőbeli kísérletekben még több elektródát használhatnak, hogy jobban pásztázhassák az agyat.

A kísérletek nem öncélúak: az eredményeket felhasználhatják a természetes beszéd zeneiségének helyreállításánál a fogyatékos neurológiai állapotú betegeknél.

Ha máskor is tudni szeretne hasonló dolgokról, lájkolja a HVG Tech rovatának Facebook-oldalát.

Ajándékozz éves hvg360 előfizetést!

Ajándékozz éves hvg360 előfizetést!