Ma már rengeteg helyen használják a világban az érzelemfelismerő technológiát, mégis nagyon keveset lehet róla tudni. A Cambridge-i Egyetem kutatói most ennek veszélyeire igyekeznek felhívni a figyelmet.

Az elmúlt években nyilvánvalóvá vált, hogy az arcfelismerő technológiának komoly veszélyei vannak. Bár a biometrikus azonosítás ezen formája növelheti a felhasználói adatok védelmét, az ilyen rendszerekkel nagyon könnyű visszaélni: Kínában például az ujgur kisebbség tagjainak azonosítására használja a rezsim, az Egyesült Államok több városában pedig betiltották a használatát, mert a mesterséges intelligencia gyakran rasszista döntéseket hozott.

Ám míg a legtöbben az arcfelismerő rendszerek miatt aggódnak, van egy másik technológia is, aminek használata szintén komoly aggályokat vet fel. Az érzelmek felismerése egy óriási iparággá nőtte ki magát, amit a közlekedéstől a piackutatásig számos területen lehet használni. A kritikusok szerint azonban mindez nemcsak az adatvédelem szempontjából problémás, de pontatlan is, ráadásul az előítéletektől sem mentes a működése.

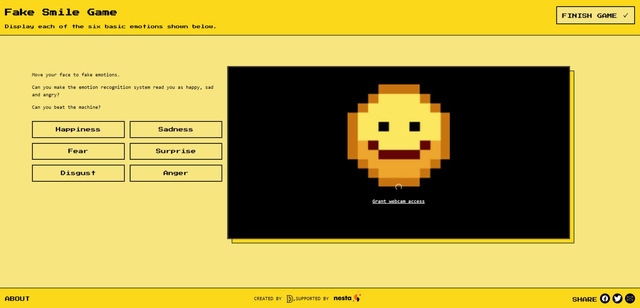

A Cambridge-i Egyetem kutatói létrehoztak egy weboldalt, az Emojify-t, ahol a felhasználók a saját webkamerájuk segítségével nézhetik meg, hogy mennyire pontos az érzelemfelismerő algoritmus. A szakembereknek ezzel két céljuk van: egyfelől lehetőséget adnak a felhasználóknak arra, hogy megpróbálják átverni az algoritmust. Ehhez különböző érzelmeket kell produkálniuk úgy, hogy az algoritmus más eredményre jusson, mint amit valójában látni. Emellett megmutatják, mennyire alulteljesít a rendszer, amikor az érzelmet kontextusában kellene felismernie. A képeket az ígéretek szerint a rendszer nem tárolja el, azok végig a felhasználó számítógépén maradnak.

Alexa Hagerty, a projekt vezetője és az egyetem kutatója szerint míg az emberek az utóbbi időben sokat hallhattak az arcfelismerő rendszerekről és azok hátulütőiről, arról már sokkal kevesebbet tudnak, mennyire elterjedten használják az érzelemfelismerős rendszereket. Találkozhatunk velük egy állásinterjún, az oktatásban vagy épp a repülőtereken – idézi őt a The Guardian.

A szakember szerint az Egyesült Államoktól Kínáig mindenhol alkalmazzák az érzelemfelismerő technológiát. A sencseni Taigusys nevű cég például az otthoni ápolástól kezdve a börtönökig szinte mindenhol használja a mesterséges intelligenciát, míg az indiai Lucknow városának vezetői azt tervezik, hogy a nemi erőszaktól szorongó nők felismerésére használják majd azt. Ez utóbbi terv egyébként komoly kritikákat kapott a különböző jogvédő szervezetektől.

Hagerty ugyanakkor megjegyzi: maga a technológia nem az ördögtől való, ugyanakkor figyelembe kell venni a felmerülő etikai és egyéb aggályokat is. A szakember szerint az emberi érzelmek túlságosan összetettek ahhoz, hogy az arcról le lehessen olvasni azokat. Gondoljunk csak arra, hogy ha valaki el akarja rejteni a fájdalmát, és a szomorú arckifejezés helyett azt látja a rendszer, hogy mosolyog.

A kutatók az Emojify nevű weboldalt is azért hozták létre, hogy megmutassák az embereknek, milyen könnyen félre lehet vezetni a rendszert. Vidushi Marda, az Article 19 nevű emberijogi szervezet egyik vezetője szerint az érzelemfelismerő rendszer használata rendkívül aggasztó, mert nemcsak pontatlan, de nem egyenlő mércével méri az embereket, a használata ráadásul ellentétes az emberi jogokkal.

Ha máskor is tudni szeretne hasonló dolgokról, lájkolja a HVG Tech rovatának Facebook-oldalát.

Ajándékozz éves hvg360 előfizetést!

Ajándékozz éves hvg360 előfizetést!