A Runway továbbfejlesztette mesterséges intelligenciáját, így már egy leírt utasítást is képes értelmezni, majd videóvá konvertálni a szöveget.

Az elmúlt időszakban többször is hallhattunk már az OpenAI fejlesztéséről, a DALL-E-ről, ami egy megadott szöveg alapján generál képet. Léteznek azonban már olyan, szintén a mesterséges intelligenciára épülő megoldások, amelyek nem statikus, hanem mozgóképet állítanak elő – szintén egy bevitt szöveg alapján.

A Runway nevű startup Gen-2 nevű videomodellje ilyen. Míg az első változat egy meglévő videót változtatott meg vagy egészített ki, az új modell lehetővé teszi, hogy egy fényképet, vagy akár csak egy egyszerű szöveget adjanak meg a felhasználók a rendszernek, ami abból legenerálja a videót.

A Facebook anyacége, a Meta egyébként még 2022-ben mutatta meg, mire képes az ugyanígy működő saját megoldása.

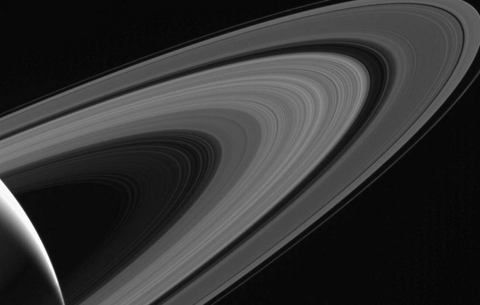

A Runway szerint a második generációs modell gyorsabb és hatékonyabb, mint a korábbi verzió. Emellett a felhasználók számára lehetővé teszi, hogy finomhangolják „a kimeneti jellemzőket néhány referenciakép alapján.” A végeredmény ilyesmi lesz.

Generate videos with nothing but words. If you can say it, now you can see it.

— Runway (@runwayml) March 20, 2023

Introducing, Text to Video. With Gen-2.

Learn more at https://t.co/PsJh664G0Q pic.twitter.com/6qEgcZ9QV4

A videók nem élethűek, de valószínűleg csak idő, nem is túl hosszú idő kérdése, hogy azok legyenek. A rendszert bárki kipróbálhatja, csak regisztrálnia kell ezen az oldalon.

Ha máskor is tudni szeretne hasonló dolgokról, lájkolja a HVG Tech rovatának Facebook-oldalát.

Ajándékozz éves hvg360 előfizetést!

Ajándékozz éves hvg360 előfizetést!