Egy amerikai nő beperelte az Apple-t amiatt, hogy a vállalat nem használja azt a 2021-ben bemutatott eszközét, ami gyermekpornográfiával kapcsolatos képekre rámutatva segített a pedofilok leleplezésében.

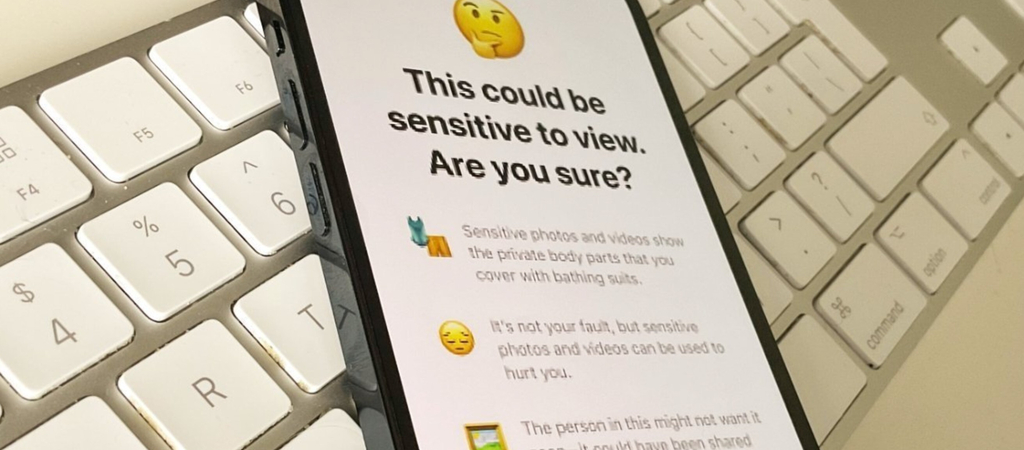

Az Apple korábban is odafigyelt a kicsik védelmére, így nem volt meglepő az a hír, hogy egy olyan eszközön dolgozik, ami visszaszorítaná a gyermekpornográfiát. 2021-ben be is jelentette, hogy más gyermekbiztonsági funkciók mellett bevezeti a CSAM (child sexual abuse material, azaz a gyerekek szexuális zaklatását felhasználó anyagok) felismerését az iCloud Photos szolgáltatásban. A NeuralHash nevű eszközzel tulajdonképpen egy olyan rendszert akart bevezetni, amely a felhasználók iCloud-fotóit automatikusan átvizsgálja, és ha gyanús képeket talál, akkor azokat jelenti a hatóságoknak.

A vállalat azonban jelentős ellenállással szembesült az adatvédelmi jogvédők, biztonsági kutatók és politikai csoportok részéről, akik azt állították, hogy ez a technológia megnyithatja az utat más kormányzati megfigyelés-kérések felé is.

Az Apple ezt követően leállította a fejlesztést, 2022 végére megnyirbálta a tervek egy részét, beleértve a képek iCloudban történő átvizsgálását. Akkor úgy nyilatkoztak, hogy számos adatvédelmi és biztonsági kutatóval, digitális jogokkal foglalkozó csoporttal és gyermekbiztonsági szószólóval együttműködve arra a következtetésre jutottak, hogy nem tudják továbbfejleszteni a CSAM-ellenőrző mechanizmust, még akkor sem, ha kifejezetten a magánélet védelmét szolgálja.

Könnyen elképzelhető, hogy ez a döntésük igen sokba fog kerülni. Egy Észak-Kaliforniában benyújtott kereset most azt állítja, hogy az Apple korábban bejelentett gyermekbiztonsági eszközei alkalmazásának elmulasztása lehetővé tette a káros tartalmak tovább terjedését, ami folyamatos károkat okoz az áldozatoknak. Emellett több pontban is vádolják a cupertinói vállalatot. Ezek egyike a kifejlesztett eszközök használatának elmulasztása. Annak ellenére, hogy az Apple bevezette a NeuralHasht a CSAM észlelésére és eltávolítására, végül nem használja azt, így a visszaélésszerű anyagok nem észlelhetők és hozzáférhetők maradtak.

Egy másik pont a CSAM aluljelentése. Az olyan technológiai óriásokhoz képest, mint a Google és a Facebook, az Apple következetesen sokkal kevesebb CSAM-esetet jelentett az Eltűnt és Kizsákmányolt Gyermekek Nemzeti Központjának (NCMEC). 2021-ben az Apple mindössze 267 bejelentést tett, míg a Google és a Facebook egy-egy milliónál is többről számolt be.

Ugyancsak vádolják azért, hogy előtérbe helyezték az adatvédelemet a biztonsággal szemben. Az Apple vezetőinek belső kommunikációja állítólag elismerte, hogy a vállalat a bizalom és a biztonság rovására helyezte előtérbe a felhasználói adatvédelmet, így potenciálisan előnyben részesítette a CSAM megosztását.

A kereset az Apple gyakorlatának megváltoztatására irányul, és egy lehetséges 2680 fős áldozatcsoportot kompenzálna. A törvény szerint a gyermekek szexuális zaklatásának áldozatai legalább 150 000 dollár kártérítésre jogosultak, ami azt jelenti, hogy a teljes kártérítés, a tipikusan megháromszorozódó kártérítéssel, meghaladhatja az 1,2 milliárd dollárt, ha az esküdtszék megállapítja az Apple felelősségét.

Az Apple nem reagált azonnal a perrel kapcsolatos megjegyzéskérésre, de a cég a napokban kiadott egy közleményt. Fred Sainz szóvivő rámutatott azokra a biztonsági eszközökre, amelyeket a vállalat bevezetett az illegális képek terjedésének visszaszorítása érdekében, illetve még a következőket mondta: „A gyermekek szexuális zaklatását tartalmazó anyagok undorítók, és elkötelezettek vagyunk küzdeni azért, hogy a ragadozók ne sodorják veszélybe a gyermekeket. Sürgősen és aktívan újítunk, hogy leleplezzük ezeket a bűncselekményeket anélkül, hogy veszélyeztetnénk felhasználóink biztonságát és magánéletét”.

Ha máskor is tudni szeretne hasonló dolgokról, kövesse a HVG Tech rovatának Facebook-oldalát.

Ajándékozz éves hvg360 előfizetést!

Ajándékozz éves hvg360 előfizetést!