Nem titok, hogy a többi technológiai óriáshoz hasonlóan a Meta is komolyan veszi a mesterséges intelligenciát. A vállalat egyik új modellje érdekes dolgokra képes, ha „meglát” egy képet.

Korábban már beszámoltunk a Meta LLaMA nevű nyelvi modelljéről, de persze nem ez az egyetlen érdekesség a vállalat MI-tarsolyában. Nemrégiben közzétettek egy újabb modellt (Segment Anything Model, SAM), amely akár felszólításra, akár szövegbevitelt követően képes azonosítani az egyes objektumokat egy képen, méghozzá az objektumokhoz tartozó képpontok alapján.

A képek szegmentálása kihívást jelent, különösen akkor, ha összetett jelenetekről van szó, amelyek több, eltérő alakú, méretű és megjelenésű objektumot is tartalmaznak. A legtöbb létező képszegmentációs módszer nagy mennyiségű megjegyzéssel ellátott adatot igényel a betanításhoz, ami költséges és időigényes lehet. A Meta ezt a problémát a SAM modellel akarja megoldani.

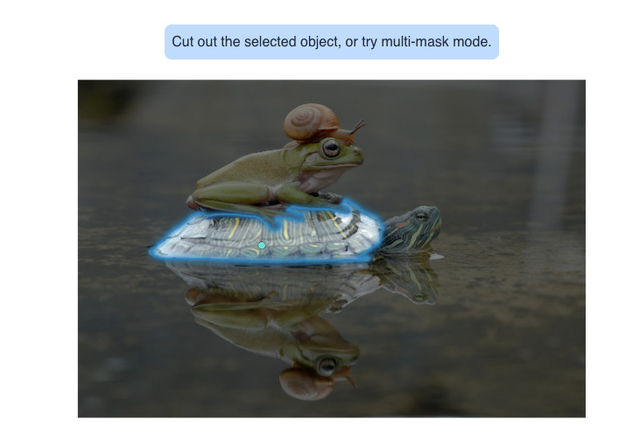

A szegmentálás az a folyamat, amikor egy objektumot elválasztanak a hátterétől vagy más objektumoktól, és létrehoznak egy maszkot, körvonalazva annak alakját és határait. A Segment Anything Model egy olyan új és hatékony mesterségesintelligencia-modell, amely kiváló minőségben és hatékonysággal képes szegmentálni egy képen vagy videón bármely objektumot. A SAM-modellel a szerkesztési, összeállítási, nyomon követési, felismerési és elemzési feladatai könnyebbé válhatnak.

A SAM több szempontból is különbözik a többi szegmentációs modelltől. Mindenekelőtt kérhető, ami azt jelenti, hogy különféle beviteli módszereket lehet használni a szegmentálandó objektum meghatározásához, például egy keretet lehet rajzolni egy személy arca köré. Több objektum kiválasztására akár több felszólítást is adható egyszerre.

A SAM-et 11 millió képből és 1,1 milliárd maszkból álló hatalmas adatkészletre képezték ki, amely az eddigi legnagyobb szegmentációs adatkészlet. Ez az adatkészlet tárgyak és kategóriák széles skáláját fedi le, például állatokat, növényeket, járműveket, bútorokat, élelmiszereket stb. A SAM általánosító képességének és az adatok sokféleségének köszönhetően olyan objektumokat is képes elkülöníteni, amelyeket még soha nem látott. Különböző módokon is szegmentálhat objektumokat, például infravörös képeket vagy mélységtérképeket.

A SAM és a hozzá tartozó adatkészlet, a több mint 1,1 milliárd szegmentációs maszkot tartalmazó Segment Anything 1-Billion (SA-1B), alkalmazások széles körét teszi majd lehetővé. A Meta szerint a SAM például használható lesz olyan alkalmazások működtetésére, amelyek megkövetelik, hogy bármely képen lévő objektum megtalálását és szegmentálását számos tartományban. A modell a jövőben egy nagyobb teljesítményű, szélesebb körű MI összetevőjévé válhat, és felhasználható lehet AR és VR alkalmazások fejlesztésére, az objektumok kiválasztására az alapján, hogy a felhasználó hol keres. A SAM-et, akárcsak a már említett LLaMA-t, egyelőre kutatási célokra készítette a Meta. A modell megengedő nyílt licenc (Apache 2.0) alatt érhető el.

Maga a SAM alapú technológia egyébként nem teljesen új a Meta életében: korai változatát már használják, elsősorban a Facebookon és az Instagramon, ahol a felhasználók fotókat címkéznek, moderálják a tiltott tartalmakat, és táplálják azokat az algoritmusokat is, amelyek meghatározzák, hogy mely bejegyzéseket jelenítsék meg a felhasználóknak.

Ha máskor is tudni szeretne hasonló dolgokról, lájkolja a HVG Tech rovatának Facebook-oldalát.

Ajándékozz éves hvg360 előfizetést!

Ajándékozz éves hvg360 előfizetést!