Nukleáris opció jöhet a mesterséges intelligencia szabályozásában, csak senki nem tudja, hogyan kellene csinálni

Úgy tűnik, a mesterséges intelligencia kordában tartása meghaladja létrehozóinak erejét. A szakma egy része állami ellenőrzést kezd sürgetni. Példaként felvetődött a nukleáris energia szabályozása.

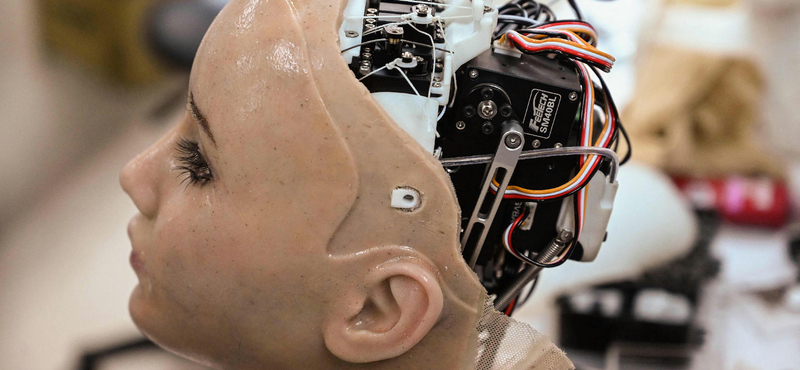

A mesterséges intelligencia olyan veszélyes lenne, mint az atombomba? Vagy olyan hasznos, mint az áramtermelés és a sugárterápia? Vagy mindkettő igaz? És ha veszélyes, hogyan lehet elejét venni a bajnak? A kérdések nem légből kapottak. Az utóbbi hetekben valóban szóba hozta több szakértő, köztük a ChatGPT-t fejlesztő OpenAI vezetői: a mesterséges intelligencia (MI) ellenőrzésére olyasfajta nemzetközi intézményt kellene létrehozni, mint a hidegháborús években életre hívott Nemzetközi Atomenergia-ügynökség (IAEA).

A párhuzam meghökkentő lehet. Legalábbis egy atomszakértő, Aszódi Attila, a BME Nukleáris Technikai Intézetének professzora azt mondta: akkor kezdett igazán aggódni az MI miatt, amikor látta, hogy az információtechnológiai szakma szereplői ennyire meg vannak ijedve a saját művüktől.

„Lehetnek olyan szempontok, amelyekre a laikusok nem is gondolnak?”

Annyi bizonyos, hogy az MI-vel foglalkozó cégvezetők és kutatók sorra teszik közzé figyelmeztető nyílt leveleiket. A márciusi, hamar lehetetlennek bizonyuló javaslat, a fejlesztések egy részének féléves felfüggesztése immár a múlté, most a szabályozás, ellenőrzés került napirendre, és feltűnő, hogy az érintettek nem annyira a saját szakmájuk önszabályozását sürgetik, hanem állami, nemzetközi beavatkozást várnak el. Ezzel Kozák Ákos társadalom- és jövőkutató, az Egyensúly Intézet társalapítója is egyetért. „Jobb, ha ezt nem az it-ipar csinálja, mert akkor olyan lesz, mint a Facebook, arról pedig láttuk, hogy milyen problémákat okoz a világban” – utal arra, hogy mennyire nem jól működik a közösségi hálózat önszabályozása, pedig ez átláthatóbb feladat, mint az MI ellenőrzése.